구글 서치 콘솔에서 구글 로봇이 페이지 생성에서 제외시키는 이유는 대략 아홉까지 정도로 추려볼 수 있다. 이유 항목들은 다양하지만 실제로 그 의미를 살펴보면 블로그 관리자 입장에서 특별히 신경 쓰지 않아도 되거나 시간이 지나면 알아서 처리되는 것들 또는 큰 문제가 아닌 것들이 대부분이다.

이번 포스팅은 아홉 가지 제외 항목 중 'robots.txt에 의해 차단됨'에 알아보고자 한다.

robot? robots.txt?

'robot'이란 각 포털사이트에서 온라인에 존재하는 모든 정보들을 수집하고 관리하는 소프트웨어를 말한다. 네이버나 다음, 빙, 구글 등 우리가 사용하며 알고 있는 포털사이트는 모두 이 소프트웨어에 의해 정보가 수집되고 관리된다. 포털 사이트 사용자가 원하는 정보를 검색했을 때 노출되는 사이트나 페이지들은 이 로봇에 의한 경우가 많다. 로봇들은 온라인 세계를 돌아다니면서 정보들을 찾고 수집하며 자신의 입맛(로직)에 맞는 것들을 선택해서 노출시키는 것이다.

구글 SEO 로직을 공부하는 이유는 구글 로봇이 좋아하는 로직에 맞게 써야 구글이라는 세계적인 검색엔진에서 나의 글이 수집되어 검색자에 의해 노출될 확률을 높일 수 있기 때문이다. 검색 시 첫 페이지, 그중에서도 스크롤을 내리지 않고도 노출되는 위치에 내 포스팅이 랭크된다면 해당 키워드로 찾아 들어온 검색자들의 유입이 많아지는 것은 당연한 일이다. 이는 곧 애드센스 수익과 연관되는 일이다.

어쨌든, 이 로봇이 뭔지는 이제 알겠는데 robots.txt란 또 무슨 말일까. robots.txt란 쉽게 말해서 교통표지판과 같은 역할을 한다고 보면 된다. 각 포털의 로봇들이 바로 이 robots.txt란 안내 표지판에 따라 움직인다. 교통표지판의 기호들이 세계 표준을 따르듯, robots.txt 역시 그렇다. 각 포털의 로봇들은 정보 수집을 위해 사이트나 페이지를 액세스 하는데, 가장 먼저 찾아 읽어 내려가는 것이 바로 robots.txt이다.

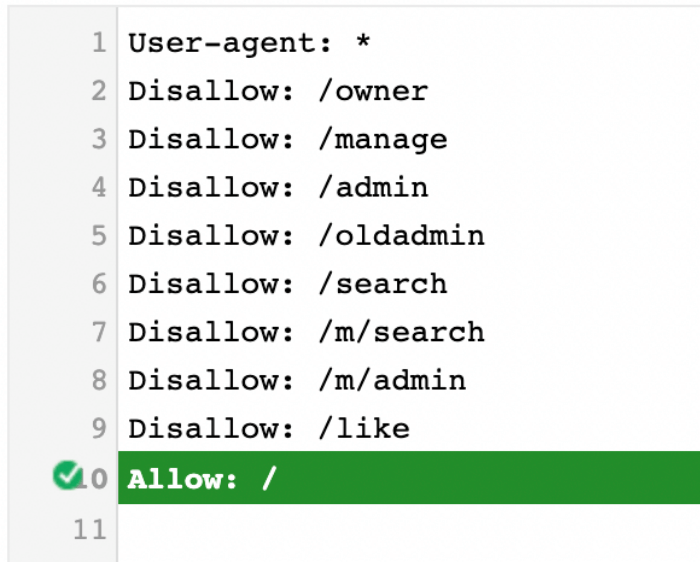

이 안에는 로봇이 어떤 정보는 읽고 수집해도 되고, 어떤 정보는 접촉조차 하지 말라는 내용이 적혀있다. 예를 들어 티스토리 사이트는 아래 사진처럼 명시된 것이 기본으로 설정되어 있다.

티스토리 기본 설정 robots.txt 의미

첫 단락의 'User-agent: *' 여기서 *이란 모든 로봇들을 의미한다. 단락의 마지막 'Allow: /'는 / 이하 모든 url에 접속하는 것을 허용한다는 의미다. 즉, 모든 로봇들이 티스토리 사이트 어느 곳이든 접속하는 것을 허용한다는 말이다. 하지만 이 사이에 몇 개의 조건들이 달려있는 걸 볼 수 있다.

바로 'Disallow'에 있는 내용들이다. /admin이나 /manage, /owner 같은 게 보이는데, 이는 블로그를 운영하는 블로거 개인의 보안 문제와 관련된 url이다. 티스토리 관리자 모드에서 블로거가 블로그를 설정하는 모든 페이지의 접속 경로 url은 모두 위와 같은 형식의 주소가 포함된다. 로봇이 이곳까지 정보를 수집해가면 안 되기 때문에(혹은 불필요하기 때문에) /manage 이하 또는 포함된 url에 대해서는 로봇의 접속을 허용하지 않는다고 명시한 것이다.

또 /search라는 검색과 관련된 것도 일반적으로 허용하지 않는다. 직접 자신의 티스토리 주소 뒤에 /search를 쳐서 검색해보면 알겠지만 그냥 블로그의 검색창 페이지가 나온다. 어떤 정보가 담긴 페이지가 아닌 검색창 접속 url을 굳이 로봇들이 수집하는 것은 불필요하고, 로봇 입장에서도 비효율적인 일이다.

두 번째 단락에서는 우리가 티스토리를 하는 이유가 드러난다. 바로 구글 로봇에 대해 명시해놓은 부분이다. 보면, 모두 허용됨으로 표시되어있다.

세 번째 단락은 bing검색 포털 사이트의 빙봇에게 30초간 딜레이를 준다고 명시되어 있다. 빙봇의 경우 굉장히 공격적으로 정보를 수집하려 달려들기 때문에, 다른 로봇들과의 충돌 및 페이지 과부하를 우려한 조치로 해석할 수 있다.

'robots.txt에 의해 차단됨' 의미와 해결방법

말이 너무 길어졌지만, 구글 서치 콘솔에서 robots.txt에 의한 차단됨 사유를 클릭해서 들어가 보면 90% 이상 '/manage'라고 적혀있는 걸 부분을 볼 수 있다. 즉 '블로그 이름. 티스토리. com/manage/-'라는 url은 티스토리가 설정한 교통표지판 robots.txt에 의해 로봇 접속이 차단되었다는 의미다.

이 차단은 위에서 설명한 대로 보안과 불필요한 수집 방지를 위해 필요한 일이기 때문에 해당 오류는 해결해야될 문제가 아니라 당연하게 표시되는 오류라고 볼 수 있다. 따라서 애초에 해결할 필요가 없으니 신경 쓰지 않아도 된다.

댓글